Thuật ngữ kho dữ liệu xuất hiện và trở nên phổ biến khi xu hướng 4.0 phát triển với tốc độ chóng mặt. Bước vào vũ trụ dữ liệu, hàng ngày phải tiếp xúc với hàng ngàn thuật ngữ kho dữ liệu rất dễ rơi vào tình trạng rối loạn thông tin.

Để ứng biến với sự chuyển đổi của thời đại, bài viết sẽ cung cấp những thuật ngữ thường dùng không thể thiếu đối với dân data.

12 thuật ngữ kho dữ liệu đơn giản phổ biến

- Business Intelligence (BI). BI là quá trình phân tích và báo cáo các dữ liệu trong quá khứ để giúp định hướng các quyết định trong tương lai. BI giúp các nhà lãnh đạo đưa ra những quyết định chiến lược tốt hơn bằng việc tìm hiểu những gì đã diễn ra trong quá khứ bằng cách sử dụng các thống kê về doanh số hoặc chỉ số vận hành.

- Data Warehouse (nhà kho dữ liệu) lầ một nơi mà tất cả các dữ liệu được thu thập bởi một tổ chức và được sử dụng để đưa ra các quyết định về quản lý.

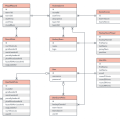

- Data Models (mô hình dữ liệu) xác định cách các tập dữ liệu được kết nối với nhau và cách chúng được xử lý và lưu trữ bên trong một hệ thống. Mô hình dữ liệu cho thấy cấu trúc của một cơ sở dữ liệu, bao gồm các mối quan hệ và các hạn chế, giúp các nhà khoa học dữ liệu hiểu dữ liệu có thể được được lưu trữ và sử dụng như thế nào là tối ưu nhất

- ETL là một loại tích hợp dữ liệu gồm 3 bước (trích xuất, truyển đổi, tải) được sử dụng để trộn dữ liệu từ nhiều nguồn khác nhau. Nó thường được khai thác để xây dựng lên các nhà kho dữ liệu (data warehouse). Một khía cạnh quan trọng của việc lưu kho dữ liệu là nó giúp gom dữ liệu từ nhiều nguồn và truyển hóa chúng thành một định dạng chung và có ích. Ví dụ, ETL bình thường hóa dữ liệu từ nhiều bộ phận kinh doanh khác nhau và xử lý để nó chuẩn hóa và thống nhất.

- Data Engineering. Nếu các kĩ sư dân dụng phải làm việc với các vật liệu xây dựng thì các kĩ sư dữ liệu làm việc với số liệu. Công việc của họ là xây dựng lên cơ sở hạ tầng mà thông qua đó, những dữ liệu được tập hợp, làm sạch, lưu trữ và chuẩn bị sẵn sàng cho các nhà khoa học dữ liệu sử dụng. Việc xây dựng một team khoa học dữ liệu mà thiếu các kĩ sư dữ liệu chẳng khác nào “chưa có ngựa mà đã sắm yên”

- Data Analyst (Chuyên viên phân tích dữ liệu) là người sử dụng dữ liệu mà Data Engineer đã chuẩn bị để xây dựng các báo cáo, đưa ra các nhận định về các chỉ số (KPI), đưa xu hướng, các mối tương quan Mục đích của báo cáo phân tích dữ liệu là để giúp lãnh đạo nắm được tình hình thực tế và tham mưu đưa ra quyết định chính xác.

- Data scientist (Nhà khoa học dữ liệu) là người phát triển những thuật toán, xây mô hình thống kê dự báo cho các Data Analyst sử dụng. Bộ kỹ năng của nhà khoa học dữ liệu bao gồm các phép đo thống kê, phân tích, kỹ năng lập trình và sự nhạy bén trong kinh doanh. Hầu hết các nhà khoa học dữ liệu có một nền tảng vững chắc về toán học hoặc các lĩnh vực khoa học khác và sở hữu bằng tiến sĩ cũng là một khả năng khác biệt

- Trực quan hóa dữ liệu (Data Visualization). Đây là một lĩnh vực chính của khoa học dữ liệu. Hình ảnh hóa dữ liệu là việc thể hiện các thông tin dạng text dưới dạng các hình ảnh trực quan để dễ dàng phát hiện và nhận ra các quy luật (pattern), xu hướng (trend) và tương quan (correlation) để giúp mọi người dễ dàng hiểu được ý nghĩa của dữ liệu.

- Khóa học về việc đưa ra quyết định (Decision Science). Trong khuôn khổ của ngành khoa học dữ liệu, các nhà khoa học quyết định áp dụng toán và công nghệ để giải quyết các vấn đề của kinh doanh, cùng với khoa học hành vi và design thinking (một quá trình nhắm tới việc hiểu người dùng cuối tốt hơn)

- Lập trình R là một ngôn ngữ lập trình và môi trường phần mềm dành cho điện toán thống kê. Ngôn ngữ R được sử dụng rộng rãi bởi các nhà thống kê và các nhà khai phá dữ liệu (data miner) để phát triển các phần mềm thống kê và phân tích dữ liệu.

- Python là một ngôn ngữ lập trình đa dụng và là một ngôn ngữ được sử dụng để vận hành và lưu trữ dữ liệu. Rất nhiều website có lưu lượng truy cập cao, như YouTube được viết bằng Python

- SQL – Structured Query Language (ngôn ngữ truy vấn có cấu trúc), là một ngôn ngữ lập trình nữa được sử dụng để thực thi các tác vụ, như cập nhật hay gọi (retrieve) dữ liệu từ một cơ sở dữ liệu.

15 thuật ngữ chuyên sâu về kho dữ liệu

- Máy học (Machine Learning) là một mảng nhỏ trong AI, máy học nhắm tới quá trình mà nhờ nó một hệ thống có thể học từ những dữ liệu đầu vào bằng việc nhận ra các quy luật trong dữ liệu đó, sau đó áp dụng những quy luật này đối với những vấn đề hay yêu cầu mới.

- Supervised Learning (Học có giám sát) là một loại máy học đặc biệt liên quan đến việc các nhà khoa học dữ liệu hành động như một người hướng dẫn để dạy cho thuật toán tạo ra những kết quả mong muốn. Ví dụ, máy tính học các xác định hình ảnh động vật bằng việc được huấn luyện dựa trên một tập các hình ảnh được gắn nhãn chính xác mỗi loài và tính cách của nó.

- Classification (Phân lớp) là một ví dụ của học có giám sát trong đó một thuật toán đặt một mẩu dữ liệu vào một danh mục tồn tại trước đó, dựa trên một tập hợp các đặc tính mà danh mục đó đã biết. Ví dụ, nó có thể được sử dụng để quyết định xem một khách hàng có thể chi tiêu hơn 20$ online hay không, dựa trên việc so sánh với những khách hàng cũng tiêu số tiền tương tự như vậy.

- Cross validation (Xác thực chéo) là một phương pháp để xác thực sự ổn định hoặc chính xác của mô hình máy học của hạn. Mặc dù có vài loại xác thực chéo, loại cơ bản nhất liên quan đến việc chia tập dữ liệu để dùng để huấn luyện thành hai phần và huấn luyện thuật toán dựa trên một phần trước khi áp dụng cho phần thứ hai. Bởi vì bạn biết đầu ra bạn nên nhận được là gì, bạn có thể đánh giá được tính xác thực của một mô hình.

- Clustering là phân loại mà không có khía cạnh học giám sát. Với Clustering, thuật toán nhận dữ liệu đầu vào và tìm những điểm tương đồng trong bản thân dữ liệu đó bằng việc nhóm các điểm dữ liệu giống nhau lại.

- Deep Learning (Học sâu) là một dạng phức tạp hơn của máy học, học sâu nhằm nói tới những hệ thống với nhiều lớp đầu vào/đầu ra, ngược với các hệ thống học nông – chỉ có một lớp đầu vào/đầu ra. Trong học sâu, cần có vài chu kì dữ liệu đầu vào/đầu ra để hỗ trợ máy tính giải quyết các vấn đề phức tạp ở thế giới thực.

- Linear Regression (Hồi quy tuyến tính) lập mô hình mối quan hệ giữa hai biến bằng việc áp một phương trình tuyến tính vào dữ liệu quan sát được. Bằng cách làm như vậy, bạn có thể dự đoán một biến chưa biết dựa trên biến liên quan đã biết. Một ví dụ đơn giản là mối quan hệ giữa chiều cao và cân nặng của một người.

- A/B Testing là một thử nghiệm ngẫu nhiên mà ở đó bạn thử nghiệm 2 biến thể để quyết định đâu là nhân tố thúc đẩy hành động tốt nhất. Ví dụ, bạn thử nghiệm 2 vị trí đặt banner để kiểm tra xem vị trí nào khiến người đọc click nhiều hơn.

- Hypothesis Testing (Kiểm định giả thuyết) là việc sử dụng thống kê nhằm xác định xác suất để một giả thuyết được đưa ra là đúng. Nó thường được sử dụng trong nghiên cứu lâm sàng.

- Statistical Power (SP) là xác suất bác bỏ giả thuyết không (null hypothesis) khi giả thuyết này là sai. Nói cách khác, nó là khả năng một nghiên cứu sẽ phát hiện ra một tác động khi có một tác động để phát hiện. SP càng cao, thì xác suất đưa ra kết luận sai rằng một biến không có tác động gì càng thấp

- Standard Error (Sai số chuẩn) là số đo độ chính xác về mặt thống kê của một ước lượng. Mẫu thống kê có kích thước càng lớn, sai số chuẩn càng nhỏ.

- Causal Inference (Suy luận nhân quả) là một quá trình kiểm tra xem có hay không một mối liên hệ giữa nguyên nhân và tác động (cause and effect) trong một tình huống cho trước. Đây là mục tiêu của nhiều phân tích dữ liệu trong khoa học xã hội và y tế. Chúng không những đòi hỏi dữ liệu và thuật toán tốt mà còn cả kiến thức chuyên môn sâu.

- Exploratory Data Analysis (EDA) là bước đầu tiên khi phân tích một tập dữ liệu. Với các kĩ thuật EDA, các nhà khoa học dữ liệu có thể tóm tắt các đặc tính chủ yếu của một tập dữ liệu và thông báo sự phát triển của các mô hình phức tạp hơn hoặc các bước logic tiếp theo.

- GitHub là một dịch vụ xuất bản và chia sẻ code, đồng thời là một cộng đồng dành cho các lập trình viên. Nó cung cấp quyền truy cập và vài tính năng làm việc nhóm, ví dụ như theo dõi bug, yêu cầu tính năng, quản lý tác vụ và cấp thông tin chung cho mọi dự án. GitHub cung cấp cả repo riêng tư và các repo miễn phí – thường được sử dụng để lưu trữ mã nguồn của các dự án nguồn mở.

- Trí tuệ nhân tạo (AI) là một hệ thống trí tuệ nhân tạo có thể thực hiện các tác vụ mà thường đòi hỏi trí tuệ của con người. Điều này nhất thiết phải bắt trước cấu trúc của não người, nó liên quan nhiều hơn tới việc sử dụng những nguyên tắc suy luận của con người như một mô hình để cung cấp các dịch vụ hoặc tạo ra các sản phẩm tốt hơn, như nhận diện giọng nói, ra quyết định và dịch ngôn ngữ.

Như vậy với 27 thuật ngữ kho dữ liệu gồm cả cơ bản và chuyên sâu INDA hy vọng đã chia sẻ được tới bạn kiến thức cũng như giải đáp được những thắc mắc bạn đang gặp phải.

Nguồn: Internet