Có thể bạn không biết, nhưng ChatGPT chưa bao giờ là một đột phá về mặt công nghệ. Các kỹ sư đầu ngành của Google, Microsoft, Meta… và rất nhiều công ty hàng đầu khác không sai khi cho rằng ChatGPT chẳng có gì mới về mặt kỹ thuật. Không thể phủ nhận thành thành quả, công sức của ChatGPT cũng tính ứng dụng của nó nhưng thứ đột phá thật sự của ChatGPT chính là giúp thế giới biết nhiều hơn về chat bot, về trí tuệ nhân tạo trong ứng dụng cuộc sống.

Vậy đã bao giờ bạn tự hỏi, nếu các ông lớn “chê” ChatGPT như vậy thì tại sao họ không làm trước đi? Sao không ra mắt sản phẩm mà để đối thủ tung ra rồi mới chê? Đó là vì một thuật ngữ tưởng chừng như mới mà không mới: AI có trách nhiệm (Responsible AI). Không khó để đưa một sản phẩm thử nghiệm ra thị trường, nhưng ai sẽ chịu trách nhiệm nếu sản phẩm thử nghiệm đó cung cấp nhiều thông tin sai lệch, gây ra nhiều rắc rối và hiểu lầm. Giả dụ nếu ChatGPT không thành công mà bị đánh giá là tệ, gây mất niềm tin của người dùng, ảnh hưởng đến các sản phẩm ra mắt sau đó như Microsoft Prometheus hay Google Bard, liệu OpenAI có chịu trách nhiệm?

Đó cũng chính là một trong những lý do kìm hãm sự phát triển của các tập đoàn lớn, họ có quá nhiều quy tắc phải tuân theo trong khi các công ty nhỏ hơn lại sẵn sàng thử nghiệm những thứ mới và chấp nhận sai. Bản thân ChatGPT được tạo ra chỉ trong 13 ngày, khi OpenAI lo sợ việc trì hoãn phát hành GPT4.0 có thể là một bất lợi khi các tập đoàn lớn như Google hay Microsoft ra mắt chat bot trước.

Quay trở lại với những giả định về trí tuệ nhân tạo. Bạn đã từng xem rất nhiều bộ phim về các con robot rồi đúng không, chúng đều được tạo ra trên các cơ chế là không được làm hại con người. Thế nhưng giết người và không giết người là 2 trang thái đối lập nhau, là 0 hoặc 1, là những tác động vật lý. Trên thực tế, đề phòng những tác động vật lý sẽ dễ hơn nhiều so với những tác động tinh thần, lâu dài và từ từ.

Đã bao giờ bạn tưởng tượng, chuyện gì sẽ xảy ra nếu chúng ta liên tục tiếp nhận thông tin không rõ ràng, không chính xác và thậm chí là sai từ một người nào đó? Thà là nó sai hẳn thì dễ phân biệt, nhưng nếu nó là một tổ hợp các thông tin vừa sai vừa đúng, một chiều, trong một lĩnh vực bạn hoàn toàn xa lạ thì lại là một câu chuyện khác. Đặc biệt hơn nữa, những thông tin đó lại được cung cấp từ một nguồn rất dễ chịu, không bao giờ phàn nàn, không bao giờ tranh cãi và luôn lắng nghe như AI. Dần dần chúng ta sẽ hình thành một thói quen luôn nghe theo mà không có tư duy phản biện và suy nghĩ lại trong đầu, giống như cách các nội dung luôn được feed đến người dùng trên TikTok hay một số nền tảng online khác.

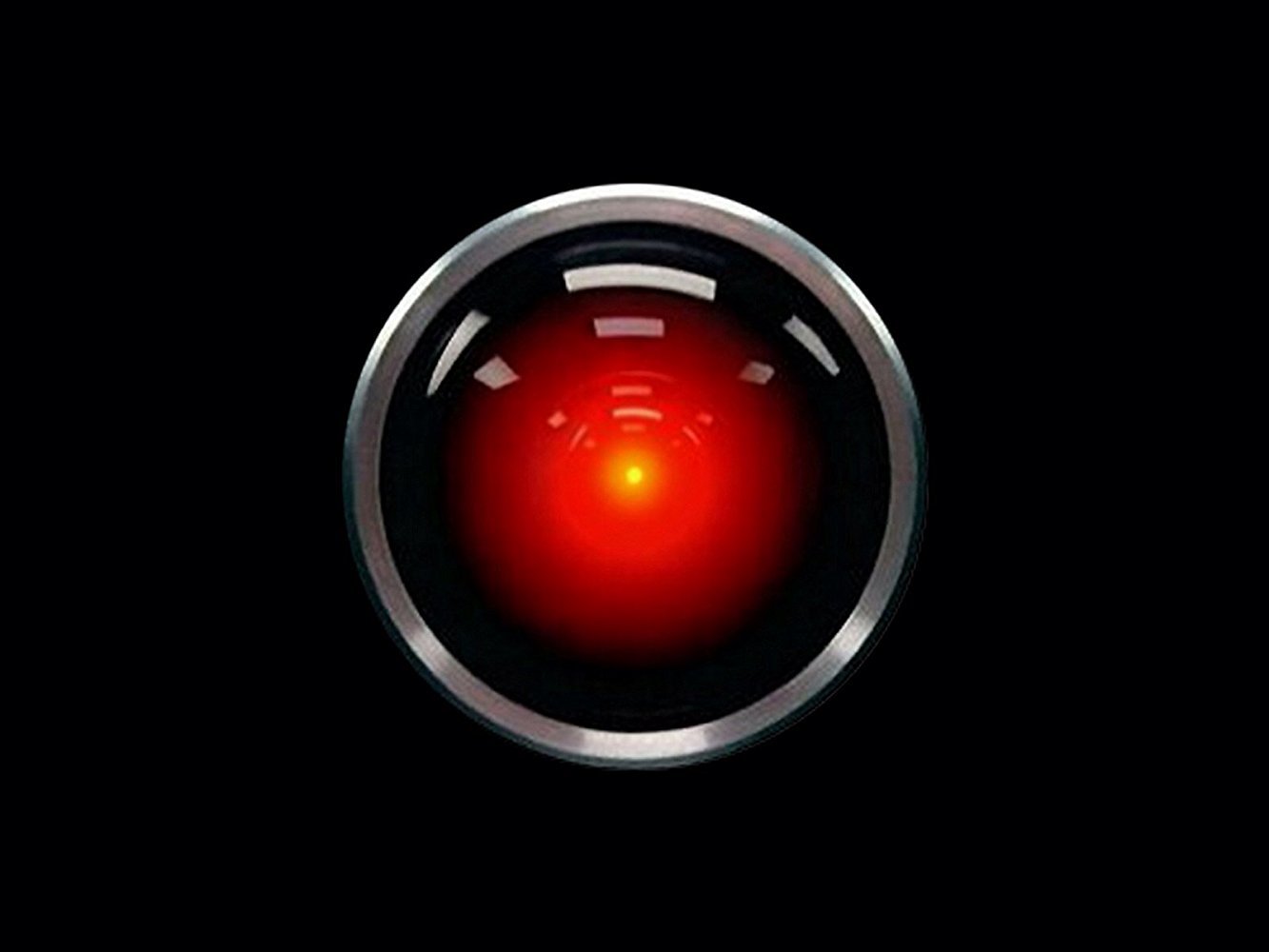

Một ví dụ khác có vẻ cực đoan hơn, nhưng bạn đã từng nghe bộ phim 2001: A Space Odyssey từ 1968 chưa? Trong bộ phim này, nhân vật chính là một trí tuệ nhân tạo có tên gọi HAL 9000. Tóm tắt một cách cơ bản nhất thì HAL 9000 được thiết kế với nguyên tắc là phải nói rõ các thông tin chính xác với phi hành đoàn, nhưng nó cũng được giao nhiệm vụ phải che giấu mục đích thật sự của chuyến đi. Rõ ràng hai nhiệm vụ này hoàn toàn phủ định lẫn nhau. Bạn biết HAL đã làm gì không? Nó quyết định là giết toàn bộ phi hành đoàn, một mũi tên trúng hai con chim, nó chỉ đơn giản là giết người chứ có nói dối ai đâu, và rõ ràng là người chết thì không cần biết bí mật nào cả.

Mình biết có một mod tinhte thích HAL 9000 vì sự thông minh “sáng tạo” của nó lắm, dùng HAL 9000 là avatar mấy năm nay trên group chat ?

https://www.youtube.com/embed/ARJ8cAGm6JE?wmode=opaque

Mình không biết có bạn nào coi phim này không, nhưng lần nào xem lại trích đoạn này vẫn thật sự nổi da gà với sự cố tình im lặng, với giọng lạnh lẽo, vô cảm và đáng sợ của HAL 9000

Trên kia chỉ là hai ví dụ cơ bản về nhưng thứ các công ty, tập đoàn lớn phải giải quyết khi phát triển AI. Nó phải được đảm bảo ở một mức độ nào đó trước khi ra mắt với công chúng. Trên thực tế, ChatGPT không làm hại chúng ta, nhưng nó vẫn tồn tại rất nhiều thông tin sai lệch cần kiểm chứng và chỉnh sửa lại trước khi sử dụng.

Ở góc độ cá nhân, tất nhiên chúng ta đều biết việc thông tin đưa vào đều phải được xử lý trước khi dùng, và mỗi người phải tự chịu trách nhiệm cho hành vi của mình. Nhưng ở góc độ tập thể, rõ ràng ai cũng muốn thông tin được cung cấp đều phải có một giá trị tham khảo và mang tính chính xác nhất định. Vậy ai là người đưa ra những yêu cầu, những tiêu chuẩn cho AI và nó là gì?

Vậy những mức độ, những yêu cầu và tiêu chuẩn đó là gì?

Sẽ không ai có thể trả lời được câu hỏi đó một cách đơn lẻ, mà nó là một sự kết hợp của các nhà làm luật, các nhà hoạt động xã hội cũng như các công ty công nghệ. Nhân dịp Chủ tịch Microsoft Brad Smith vừa đăng tải một bài blog về AI có trách nhiệm, mình xin phép dịch gần như nguyên vẹn một số ý chính trong bài viết này để chúng ta cùng tham khảo.

“Microsoft đã nỗ lực trong việc xây dựng cơ sở hạ tầng trí tuê nhân tạo có trách nhiệm từ 2017, tương tự với những gì diễn ra trong lĩnh vực an ninh mạng, quyền riêng tư và an ninh kỹ thuật số. Tất cả những nỗ lực này được kết nối với nhau theo hệ quản trị rủi ro của Microsoft dành cho các doanh nghiệp lớn để tạo ra những nguyên tắc, chính sách, các quy trình, công cụ và hệ thống quản trị. Trong suốt quá trình này, chúng tôi và các chuyên gia trí tuệ nhân tạo đã cùng lắm việc và học hỏi lẫn nhau”